本地离线部署AI大模型的主要原因包括以下几个方面:

- 隐私保护:在某些敏感领域,如医疗、金融等,数据的隐私性和安全性至关重要。离线部署可以避免数据在云端处理时可能泄露的风险。

- 网络问题:对于偏远地区或在低带宽环境下,云服务可能会受到网络延迟和稳定性的影响,导致用户体验不佳。本地部署则不受这些问题影响。

- 成本控制:云计算资源的成本通常随着使用量的增加而上升,特别是对于频繁使用的高计算需求模型。本地部署可以减少对云服务的依赖,从而节省成本。

- 实时性要求:在需要快速响应和即时决策的应用中(如自动驾驶、金融交易等),离线部署能够提供更快的处理速度和更低的延迟。

- 合规性和法律法规:在一些国家和地区,有严格的法规规定数据必须在本地处理或存储。遵守这些法规是进行本地离线部署的重要原因之一。

- 性能优化:对于特定的应用场景,将模型本地化可以对硬件进行定制优化,比如使用GPU、TPU等加速器,从而提升模型的执行效率和效果。

- 可靠性和可用性:在断网或电力不稳定的情况下,本地部署提供了一种更可靠的解决方案,确保服务的连续运行。

通过考虑这些因素,企业或组织可以决定是否需要进行AI大模型的本地离线部署。

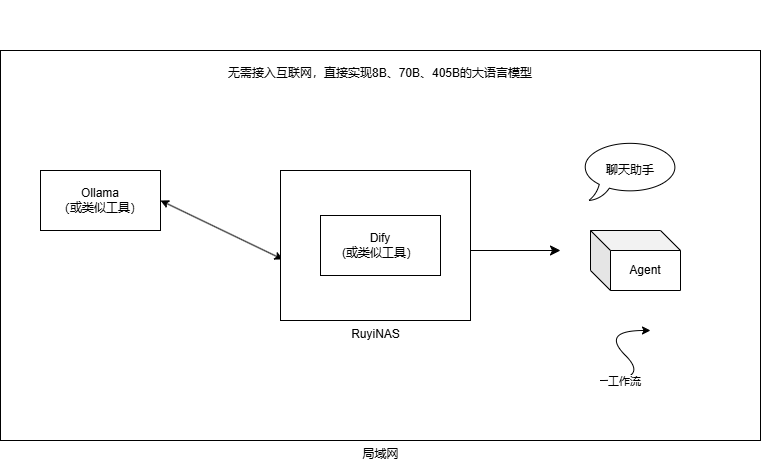

RuyiNAS离线部署系统架构图

集思乐的本地化AI训练方案包括3个部分,推理服务器、NAS和应用端,LLMS服务器提供模型处理,NAS安装dify或类似工具,存储训练样本(可加密),最终提供给调用端,整个过程无需连接互联网,不存在数据外泄的可能。

Dify是一款生成式 AI 应用创新引擎,可以提供从 Agent 构建到 AI workflow 编排、RAG 检索、模型管理等能力,轻松构建和运营生成式 AI 原生应用,提供强大的工作流、知识库、数据库等能力。RuyiNAS的应用模块可轻松安装Dify。

RuyiNAS作为存储设备,可以存储AI训练所需的数据和模型,并进行加密存储以确保不被盗用,在加装特定显卡后也可以作为边缘计算设备,进行推理应用。集思乐自有的AI支撑团队也可以协助客户实现推理服务器的安装与调试。

整个架构的优势在于可以将实现本地离线部署AI大模型,保证数据的安全性和隐私性,同时也可以减少数据传输的延迟和成本,提高AI训练的效率和质量。

保持两台机器(一台推理服务器和一台RuyiNAS)解耦离线部署方案的优势:

- 高可扩展性:使用两台独立的机器允许您根据需要更灵活地调整计算资源和存储容量。如果在某个阶段推理需求增加或数据量膨胀,可以单独升级推理服务器,而不会影响现有的NAS存储系统。

- 性能优化:将计算(推理)与存储分离可以让您对硬件进行更加精细化的配置。推理服务器可以配备高性能处理器和图形处理单元(GPU),以提供强大的计算能力;而RuyiNAS则可以选择更专注于大容量存储和数据备份功能的设备,从而实现资源的最佳利用。

- 成本效益:在某些情况下,分拆采购可以带来成本优势。对于一些特定需求或使用模式,单独优化硬件配置可能比集成一体机更为经济。

- 容错性和冗余性:两台独立的服务器意味着一个组件的故障不会导致整个系统崩溃。这种架构提供了更高的冗余度和容错能力,增强了整体系统的可靠性。

- 安全性和数据控制:通过分离计算与存储,您可以更好地管理数据安全性,并在不同层面上应用不同的访问权限和加密措施,提供更细粒度的数据保护策略。

- 维护和升级便利性:当某个组件需要维护或更新时(如推理服务器的硬件老化或NAS系统过时),只需单独更换,不会对另一个系统造成干扰,减少了整体停机时间和维护成本。

- 适应不同业务需求:根据客户的具体业务场景和未来规划,两台机器的部署方案能够提供更好的灵活性。例如,在数据密集型应用(如视频分析)中需要大量存储空间时,这种架构更为合适。